Debatte über mehr Transparenz in Sozialen Netzwerken

Visual: Anja Riese

Algorithmen begleiten alle, die sich im Internet bewegen. Suchmaschinen, Nachrichten in den Timelines, Vorschläge in Netzwerken oder die schnellste Route zum Zielort: Im Hintergrund arbeiten meist automatisierte Prozesse, die mal im Interesse der Nutzer*innen und immer im Interesse der Plattformen gestaltet sind. Ziel der Plattformen ist, Menschen möglichst lange auf ihrer Plattform zu halten oder mit Werbekund*innen in Kontakt zu bringen. Durch „lernende“ Algorithmen entstehen mindestens in sozialen Netzwerken Interessen-Blasen, die auch zum Risiko für eine vielfältige und demokratische Gesellschaft werden können, wenn sie mit Falschinformationen oder Verschwörungsmythen gefüllt sind.

Jaana Müller-Brehm von iRights.Lab skizzierte im Workshop den Zusammenhang von Algorithmen und Öffentlichkeit. Sie beschrieb, wie sich das Informationsverhalten verändert hat: Etwa drei Viertel aller Befragten informiert sich regelmäßig und hauptsächlich im Internet, knapp die Hälfte sogar ausschließlich über das Netz. Über Social Media Plattformen bezieht bereits die Hälfte der Befragten ihre Informationen. Journalistische Medien verlieren an Bedeutung, waren und sind aber für eine ausgewogene Information immer noch entscheidend. Denn Journalist*innen prüfen Informationen auf Relevanz und Richtigkeit, sie folgen Maßstäben und Mechanismen der Transparenz. Automatisierte Systeme oder eine große Zahl von Akteur*innen im Internet folgt diesen Transparenz-Maßstäben nicht. Einige nutzen sogar bewusst die algorithmischen Systeme in Sozialen Medien, um Desinformation, Hate Speech oder Verschwörungsmythen gezielt zu verbreiten. Die Teilnehmenden im Workshop erkannten darin ein Problem und suchten gemeinsam mit Expertin Jaana Müller-Brehm nach Leitlinien, die soziale Netzwerke jugendgerechter und transparenter machen können.

Ein zentraler Faktor aus Sicht der jungen Menschen: Wissenschaft muss Zugang zu den Daten der Netzwerke und Plattformen erhalten, um die Prozesse und Entwicklungen zu erforschen. Bisher geschieht das zu wenig. Die Plattformen lassen sich nicht gerne in die Karten schauen, auch wenn sie anonymisierte Daten bereitstellen könnten. Sie müssen aber überprüfbar sein und unabhängige Wissenschaft kann und soll eine zentrale Rolle dabei spielen. Außerdem müssten die Plattformen Schnittstellen bereitstellen, mit denen eine Beobachtung durch Aufsichtsbehörden und Zivilgesellschaft selbst möglich wird - ergänzend zur Wissenschaft.

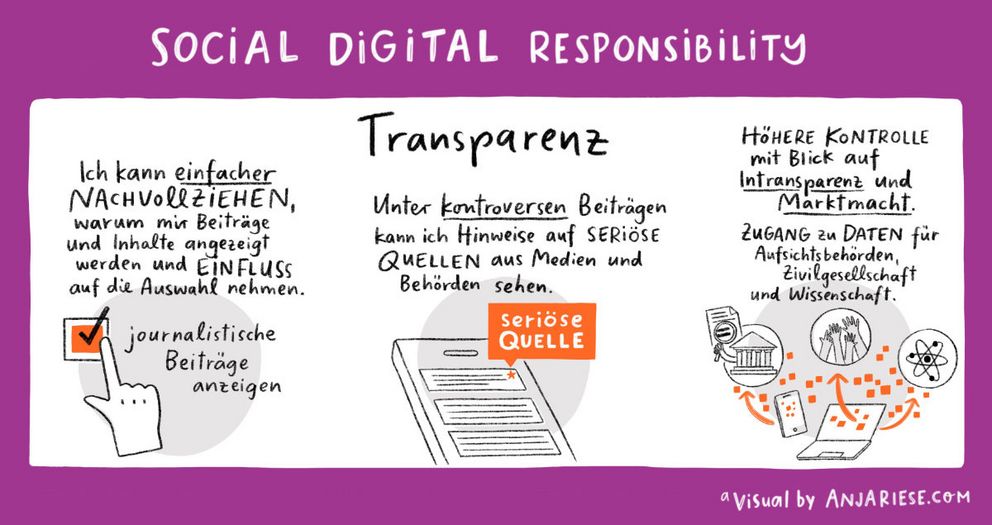

Eine konkrete Forderung: Junge Menschen wollen sehen und verstehen können, warum ihnen Beiträge und Inhalte vorgeschlagen oder angezeigt werden. Sie wollen auch selbst entscheiden können, dass sie keinen algorithmisch erzeugten Feed bekommen, sondern einen, den sie bewusst selbst wählen. Dazu wäre wichtig, dass eigene Suchverläufe nicht gespeichert werden, wenn jemand das nicht will.

Eine andere Idee: Wer sich innerhalb einer Echokammer oder Bubble bewegt, soll auch sehen können und angezeigt bekommen, was zuverlässige Quellen auf journalistischer Grundlage oder von Behörden und Wissenschaft zum Thema sagen. Technisch möglich ist das. Twitter etwa hat Tweets von Trump am Tag der Präsidentschaftswahl mit einem Hinweis versehen, dass die Informationen im Tweet durch offizielle Quellen nicht bestätigt werden.

Der Marktmacht und Intransparenz der Plattformen müsse zudem etwas entgegen gesetzt werden. Zum einen, damit zivilgesellschaftlich geregelte und kontrollierte Alternativen entstehen und wachsen können. Zum anderen, um deutlich zu machen: Wer jugendgerechte Netzwerke anbieten will, muss gesellschaftliche Regeln befolgen, die mindestens bei Algorithmen und Aufsicht erfüllt werden müssen. Die bisherigen Kontrollinstanzen reichen offensichtlich nicht aus.

Die Debatte im Workshop war intensiv. Erörtert wurde auch, ob journalistisch fundierte Inhalte bevorzugt werden sollten. Eine Debatte über die Rolle von Politik, Journalismus, Gesellschaft und Unternehmen in einer Demokratie sei notwendig. In der Interoperationalität könnte eine Chance für mehr Transparenz liegen, weil Schnittstellen zueinander offen sind - vergleichbar mit dem System der Emails und Telefone: Jede*r kann von jedem Anbieter mit anderen Personen Kontakt aufnehmen, bei Messengern ist das derzeit kaum möglich. Mehr Transparenz kann auch entstehen, wenn sich Zivilgesellschaft stärker vernetzt und eine Gegenlobby zu den Wirtschaftsunternehmen als Plattformbetreiber in politischen Prozessen aufbauen kann.

Jaana Müller-Brehm von iRights.Lab machte deutlich: Es gibt keine Technologie, der wir ausgeliefert sind. Technologie wird von Menschen gestaltet und die Debatte darüber ebenfalls. Gesellschaft kann also Einfluss nehmen und damit auch junge Menschen auf die Leitlinien für jugendgerechte Netzwerke.

Im weiteren Prozess werden aus dem Austausch in den Workshops Leitlinien für jugendgerechte soziale Netzwerke. Es gibt außerdem die Möglichkeit einer Online-Beteiligung. Das ist Ziel und Aufgabe des Projektes „Social Digital Responsibility: Jungen Verbraucher*innen eine Stimme für aktive Teilhabe an Netzwerken und Plattformen geben“.